-

Micron SSD와 NVIDIA GPUDirect Storage를 활용한 AI/ML 작업 투자 최대화Generative AI 2023. 9. 14. 19:34

2020년 7월 13일에 Wes Vaske가 작성한 블로그 포스트에서는 Micron SSD와 NVIDIA GPUDirect Storage를 결합하여 AI 및 ML 작업을 향상시키는 이점에 대해 논의하고 있습니다. Micron은 플래시 기술이 AI 애플리케이션에 미치는 영향을 적극적으로 탐구하고 있으며, 이 분야에서 혁신을 가속화하기 위해 다른 기술과의 협력을 추진하고 있습니다.

출처

https://www.micron.com/about/blog/2020/july/maximize-your-investment-in-micron-ssds-for-ai-ml-workloads-with-nvidia-gpudirect-storageMaximize Your Investment in Micron SSDs for AI/ML Workloads With NVIDIA GPUDirect Storage

Here at Micron, we are excited about the enormous innovations driven by artificial intelligence (AI). For this reason, we have been very active in exploring what effect flash can have on this new class of applications and how we can work with other amazing

www.micron.com

Vaske는 NVIDIA GPUDirect Storage 소프트웨어 초기 릴리스를 테스트한 경험을 공유하며, 이 소프트웨어는 NVMe SSD와 같은 저장 장치에서 GPU 메모리 공간으로 직접 데이터 이동을 촉진하며, I/O 버퍼링에 전통적으로 사용되는 CPU 시스템 메모리를 우회합니다. 이러한 발전은 NVIDIA의 이전 기술, 즉 CUDA 및 GPUDirect RDMA를 기반으로 하며, 데이터 과학 라이브러리가 점점 더 GPU 가속화되면서 저장 I/O에서 발생하는 병목 현상을 해결하려고 합니다.

Comparison of data path with and without GPUDirect Storage

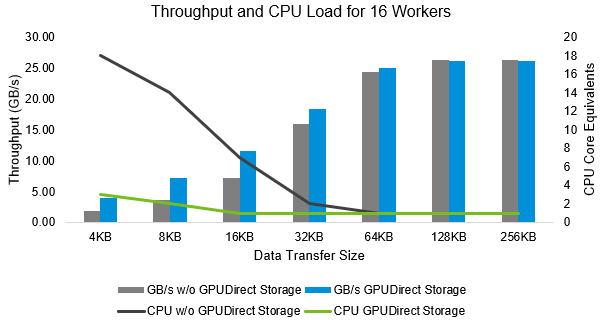

포스트에서는 NVIDIA V100 GPU와 Micron 9300 Pro NVMe SSD를 포함한 하드웨어 설정을 사용한 테스트 구성에 대한 세부 사항을 설명합니다. Vaske는 GPUDirect Storage를 사용하여 달성한 처리량, 대기 시간 및 CPU 사용률의 개선 사항을 강조하며, 특히 작은 블록 크기에 대한 테스트 결과를 제시합니다. 이 기술은 처리량의 상당한 증가, 대기 시간의 큰 감소 및 필요한 CPU 코어 수의 감소를 허용하여 GPU I/O 분야에서 주목할만한 발전을 제공합니다.

PCIe layout of SuperMicro SYS-4029GP-TVRT

마지막으로, Vaske는 NVIDIA의 GPUDirect Storage와 Micron의 데이터 센터 SSD를 결합하면 AI 솔루션을 크게 가속화할 수 있으며, 더 적은 시간에 더 많은 작업을 수행할 수 있다고 강조합니다. 그는 Micron과 NVIDIA가 성공적인 AI 솔루션을 배포하는 데 도움이 될 수 있는 방법에 대해 더 자세히 알아보기 위해 독자들에게 추가 자료를 탐구하도록 권장합니다.

CPU utilization and throughput by worker count per GPU-NVMe pair for 8x GPUs by data path for 4K I/O transfer size

GPUDirect Storage 기술은 기존 데이터 경로에 비해 AI/ML 작업에서 데이터 전송의 효율성을 어떻게 향상시키나?GPUDirect Storage 기술은 데이터를 저장 장치에서 GPU 메모리 공간으로 직접 이동시킬 수 있게 해줍니다. 이는 전통적으로 I/O 버퍼링에 사용되던 CPU 시스템 메모리를 우회하는 방식으로 작동합니다. 이러한 직접적인 데이터 이동 방식은 작은 블록 크기에서 특히 처리량을 크게 향상시키고, 대기 시간을 줄이며, 필요한 CPU 코어 수를 줄일 수 있게 해줍니다.

CPU utilization and throughput by I/O transfer size for 8x GPUs by data path with 16 workers per GPU-NVMe pair

이 기술은 데이터 과학 라이브러리가 GPU로 가속화되면서 발생하는 저장 I/O의 병목 현상을 해결하는데 중요한 역할을 합니다. 또한, 이 기술은 데이터 전송 크기가 작거나 중간일 때 특히 성능 향상을 가져다주며, 데이터 액세스 오버헤드보다 데이터 전송 시간이 지배적인 큰 전송 크기에서는 기존 데이터 경로와 별 차이가 없습니다.

따라서 GPUDirect Storage 기술은 데이터 전송의 효율성을 향상시키기 위해 GPU 가속화 애플리케이션에 중요한 도구로 작용할 수 있습니다.GPUDirect Storage에 의해 가져온 처리량과 대기 시간의 상당한 개선이 AI 애플리케이션에 미칠 수 있는 잠재적인 영향은 무엇인가?

GPUDirect Storage에 의해 가져온 처리량과 대기 시간의 상당한 개선은 AI 애플리케이션에 여러 가지 긍정적인 영향을 미칠 수 있습니다.

첫째, 처리량의 큰 증가는 AI 애플리케이션에서 더 빠른 데이터 처리를 가능하게 하며, 이는 더욱 복잡한 작업을 더 짧은 시간 내에 완료할 수 있음을 의미합니다. 이러한 향상은 특히 데이터 집약적인 AI 작업에서 중요하며, 더 큰 데이터 세트를 더 빠르게 처리할 수 있게 됩니다.

둘째, 대기 시간의 감소는 애플리케이션의 반응 시간을 개선시켜 사용자 경험을 향상시킬 수 있습니다. 또한, 대기 시간이 민감한 작업에서는 애플리케이션 성능에 중요한 영향을 미칠 수 있습니다. 예를 들어, 실시간 분석이나 자동화된 결정을 내리는 시스템에서는 낮은 대기 시간이 필수적입니다.

셋째, CPU 코어의 사용량 감소는 시스템 리소스를 더 효율적으로 활용할 수 있게 해줍니다. 이는 다른 프로세스에 더 많은 CPU 리소스를 할당할 수 있게 하여 전반적인 시스템 성능을 향상시킬 수 있습니다.

Latency and throughput by IO transfer size for 8x GPUs by data path with 16 workers per GPU-NVMe pair

결론적으로, GPUDirect Storage 기술은 AI 애플리케이션의 성능을 향상시키고, 처리 시간을 단축시키며, 더 복잡한 작업을 더 빠르게 처리할 수 있게 해줍니다, 이러한 개선 사항들은 AI 애플리케이션의 발전과 혁신을 촉진시킬 수 있습니다.테스트 구성 및 결과를 고려할 때, AI 분야의 조직들은 이 기술을 어떻게 활용하여 운영을 최적화할 수 있을까?

블로그에서 제시된 테스트 구성 및 결과를 고려할 때, AI 분야의 조직들은 GPUDirect Storage 기술을 활용하여 여러 방법으로 운영을 최적화할 수 있습니다.

1. 하드웨어 구성 최적화: 조직들은 NVIDIA V100 GPU와 Micron 9300 Pro NVMe SSD와 같은 고성능 하드웨어를 통합하여 시스템의 전반적인 성능을 향상시킬 수 있습니다. 또한, NVMe 드라이브, NICs, HBAs 등의 DMA 엔진을 활용하여 GPU 메모리 주소로 데이터를 직접 전송할 수 있는 환경을 구축할 수 있습니다.

2. 작업 효율성 향상: 조직들은 작은 블록 크기에서의 처리량 증가와 대기 시간 감소를 활용하여 AI/ML 작업의 효율성을 향상시킬 수 있습니다. 이를 통해 더 빠른 데이터 처리와 더 짧은 반응 시간을 달성할 수 있습니다.

3. CPU 리소스 절약: GPUDirect Storage 기술은 CPU 코어의 사용을 크게 줄일 수 있으므로, 조직들은 CPU 리소스를 더 효율적으로 관리하고, 다른 중요한 작업에 더 많은 리소스를 할당할 수 있습니다.

4. 데이터 과학 라이브러리의 GPU 가속화 활용: 조직들은 RAPIDS와 같은 오픈 소스 소프트웨어 라이브러리를 활용하여 데이터 과학과 분석 파이프라인을 GPU에서 완전히 실행할 수 있습니다. 이러한 라이브러리는 비 가속 라이브러리에 비해 계산 성능을 수배로 향상시킬 수 있습니다.

5. 실시간 분석 및 자동화된 결정 시스템 개선: 낮은 대기 시간 덕분에, 조직들은 실시간 분석 및 자동화된 결정 시스템을 개선하여 더 빠르고 효율적인 서비스를 제공할 수 있습니다.

이러한 방법을 통해 AI 분야의 조직들은 GPUDirect Storage 기술을 활용하여 운영을 최적화하고, AI 애플리케이션의 성능을 향상시킬 수 있습니다.'Generative AI' 카테고리의 다른 글

2D 사진을 3D 지도로 변환하는 새로운 AI 알고리즘 (2) 2023.10.11 파리 패션 위크에서의 Humane Ai 핀의 데뷔 (2) 2023.10.05 디지털 이미지에서의 복잡하지만 필수적인 경계 추적 기술 탐구 (0) 2023.09.09 맥킨지 보고서 소개: "2023년 AI의 현황: 생성형 AI의 돌파구가 생긴 해" (0) 2023.08.25 생성형 AI의 미래: 2023년 Gartner Hype Cycle에서 본 혁신과 경쟁 우위 (0) 2023.08.24